La convergencia de una serie numérica es un concepto fundamental en el análisis matemático que se encuentra en el corazón de muchas aplicaciones en diversas áreas de la ciencia y la ingeniería. Entender si una serie converge o diverge no solo es crucial para resolver problemas matemáticos, sino que también tiene implicaciones prácticas en la teoría de señales, la física y la economía, entre otros campos. En este artículo, exploraremos tres criterios esenciales que nos ayudan a determinar la convergencia de series numéricas: el criterio de la razón, el criterio de la raíz y el criterio de la integral. Cada uno de estos criterios ofrece un enfoque único y poderoso para analizar series, y juntos forman una herramienta indispensable en el arsenal de cualquier estudiante o profesional de las matemáticas. Acompáñanos a desglosar cada uno de estos criterios y a entender cómo aplicarlos de manera efectiva.

¿Qué es la convergencia de una serie numérica?

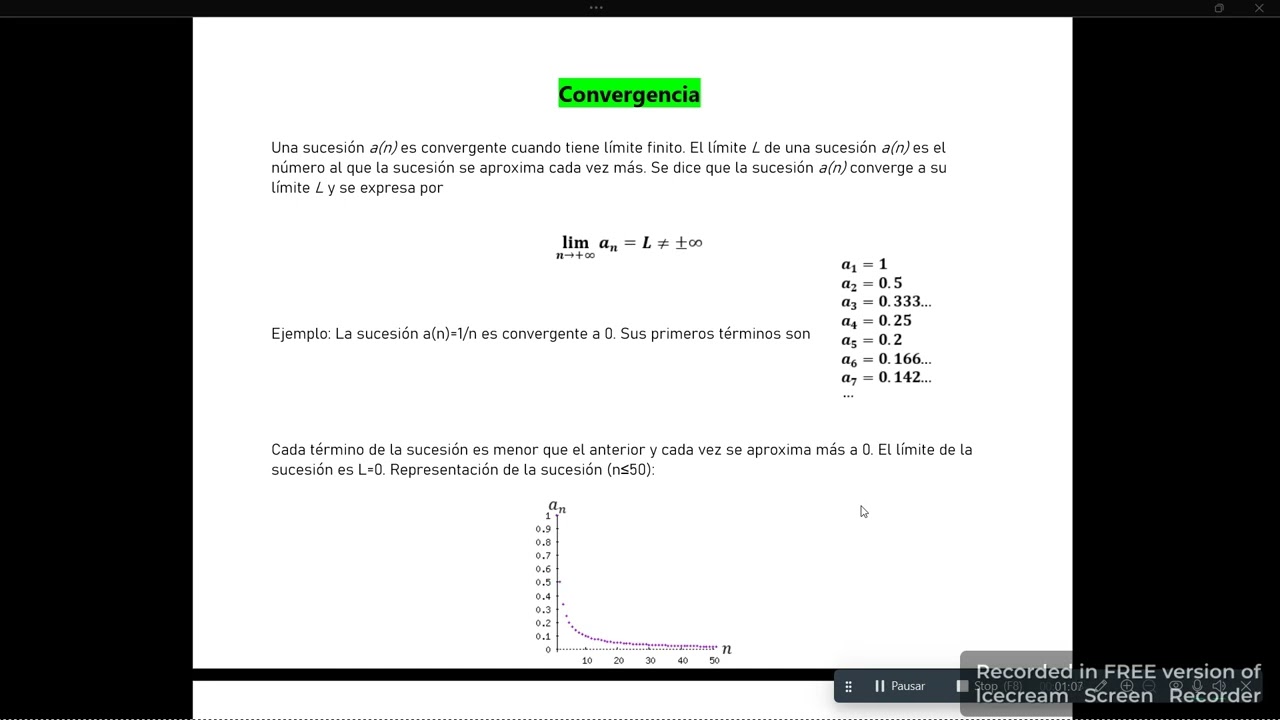

Antes de profundizar en los criterios específicos, es fundamental establecer qué significa que una serie numérica sea convergente. Una serie numérica es la suma de los términos de una sucesión, que se expresa generalmente como:

S = a1 + a2 + a3 + … + an + …

Donde cada an es un término de la sucesión. La serie se dice que converge si la suma de sus términos se aproxima a un número finito a medida que se añaden más y más términos. En otras palabras, si existe un límite L tal que:

lim (n → ∞) Sn = L

donde Sn es la suma de los primeros n términos de la serie. Si no existe tal límite, decimos que la serie diverge. Comprender esta diferencia es crucial, ya que muchas series que parecen converger a simple vista pueden, de hecho, divergir.

Ejemplos de convergencia y divergencia

Consideremos dos ejemplos sencillos para ilustrar estos conceptos. La serie geométrica:

S = 1 + 1/2 + 1/4 + 1/8 + …

converge, ya que se puede demostrar que su suma se aproxima a 2 a medida que se añaden más términos. En contraste, la serie:

S = 1 + 1 + 1 + 1 + …

diverge, ya que la suma se incrementa indefinidamente. Estos ejemplos subrayan la importancia de los criterios de convergencia que exploraremos a continuación.

Criterio de la razón

El criterio de la razón es una herramienta poderosa para determinar la convergencia de una serie. Este criterio se basa en el análisis del cociente de términos sucesivos de la serie. Para una serie de la forma:

S = ∑ an

calculamos el límite:

L = lim (n → ∞) |an+1 / an|

La interpretación de L es la siguiente:

- Si L < 1, la serie converge absolutamente.

- Si L > 1 o L = ∞, la serie diverge.

- Si L = 1, el criterio es inconcluso, y se deben aplicar otros métodos.

Ejemplo práctico del criterio de la razón

Consideremos la serie:

S = ∑ (1/n!)

Para aplicar el criterio de la razón, calculamos:

L = lim (n → ∞) |(1/(n+1)!)/(1/n!)| = lim (n → ∞) |n!/(n+1)!| = lim (n → ∞) |1/(n+1)| = 0

Como L < 1, podemos concluir que la serie converge absolutamente. Este es un ejemplo claro de cómo el criterio de la razón nos permite determinar la convergencia de una serie de manera efectiva.

Criterio de la raíz

El criterio de la raíz es otro método eficaz para evaluar la convergencia de series numéricas. Este criterio se basa en el análisis de la raíz n-ésima de los términos de la serie. Para una serie de la forma:

S = ∑ an

calculamos el límite:

L = lim (n → ∞) n√|an|

Las conclusiones son similares a las del criterio de la razón:

- Si L < 1, la serie converge absolutamente.

- Si L > 1 o L = ∞, la serie diverge.

- Si L = 1, el criterio es inconcluso y se deben usar otros métodos.

Ejemplo práctico del criterio de la raíz

Analicemos la serie:

S = ∑ (1/n2)

Aplicamos el criterio de la raíz:

L = lim (n → ∞) n√|1/n2| = lim (n → ∞) 1/n = 0

Como L < 1, podemos concluir que la serie converge. Este criterio es especialmente útil para series que involucran potencias, ya que simplifica considerablemente el análisis.

Criterio de la integral

El criterio de la integral ofrece un enfoque diferente para determinar la convergencia de series, especialmente útil para series de términos positivos. Este criterio establece que si f(x) es una función continua, positiva y decreciente para x ≥ N (donde N es un entero positivo), y si:

S = ∑ an es equivalente a la integral ∫ f(x) dx

entonces:

- Si la integral converge, la serie también converge.

- Si la integral diverge, la serie también diverge.

Ejemplo práctico del criterio de la integral

Tomemos la serie:

S = ∑ (1/np)

Para aplicar el criterio de la integral, consideramos la función f(x) = 1/xp. Evaluamos la integral:

∫ (1/xp) dx

Para p > 1, la integral converge, lo que implica que la serie también converge. Para p ≤ 1, la integral diverge, y por lo tanto, la serie también diverge. Este criterio es muy útil para series que se asemejan a funciones integrables, y proporciona una forma directa de evaluar su convergencia.

Relación entre los criterios

Es interesante notar que, aunque los criterios de la razón, la raíz y la integral son diferentes, pueden ser complementarios. Por ejemplo, en situaciones donde el criterio de la razón o el criterio de la raíz no proporcionan conclusiones definitivas (es decir, cuando L = 1), podríamos recurrir al criterio de la integral para obtener una respuesta clara. Además, algunos problemas complejos pueden beneficiarse de un enfoque combinado, utilizando diferentes criterios para validar los resultados.

¿Cuándo utilizar cada criterio?

Elegir el criterio adecuado para evaluar la convergencia de una serie puede ser crucial para simplificar el proceso. Aquí hay algunas pautas sobre cuándo usar cada criterio:

- Criterio de la razón: Ideal para series con términos factoriales o exponenciales, donde el cociente de términos sucesivos se puede calcular fácilmente.

- Criterio de la raíz: Útil para series que involucran potencias, ya que facilita el cálculo de la raíz n-ésima de los términos.

- Criterio de la integral: Mejor para series que se asemejan a funciones continuas y positivas, donde la comparación con una integral es directa.

¿Qué significa que una serie numérica converge?

Una serie numérica converge cuando la suma de sus términos se aproxima a un número finito a medida que se suman más términos. Esto implica que existe un límite específico al que la serie se dirige, lo que es crucial para aplicaciones en matemáticas y ciencias.

¿Qué hacer si el criterio de la razón o la raíz es inconcluso?

Si al aplicar el criterio de la razón o la raíz obtienes L = 1, puedes considerar usar el criterio de la integral o explorar otros métodos, como el criterio de comparación o el de la serie alternante, dependiendo de la naturaleza de la serie en cuestión.

¿Los criterios de convergencia se aplican solo a series numéricas?

Principalmente, estos criterios se aplican a series numéricas, pero algunos de ellos pueden extenderse a otras áreas, como series de funciones. Sin embargo, su aplicación principal y más efectiva se encuentra en el contexto de series numéricas.

¿Por qué es importante estudiar la convergencia de series?

Estudiar la convergencia de series es fundamental porque muchas técnicas matemáticas y físicas se basan en la suma de series. Conocer si una serie converge o diverge permite a los científicos e ingenieros hacer predicciones precisas y resolver problemas complejos en diversas disciplinas.

¿Qué pasa con las series alternantes?

Las series alternantes son un caso especial donde se puede aplicar el criterio de la serie alternante, que establece que si los términos de la serie disminuyen en magnitud y tienden a cero, la serie converge. Sin embargo, es importante evaluar cada caso individualmente.

¿Se puede usar más de un criterio para la misma serie?

Sí, es completamente válido utilizar más de un criterio para evaluar la convergencia de la misma serie. A menudo, aplicar diferentes criterios puede proporcionar una comprensión más profunda de la serie y confirmar los resultados obtenidos.

¿Cuál es la diferencia entre convergencia absoluta y convergencia condicional?

La convergencia absoluta se refiere a la convergencia de la serie de los valores absolutos de sus términos, mientras que la convergencia condicional significa que la serie converge, pero la serie de los valores absolutos diverge. Esta distinción es importante para entender la naturaleza de la convergencia de una serie.